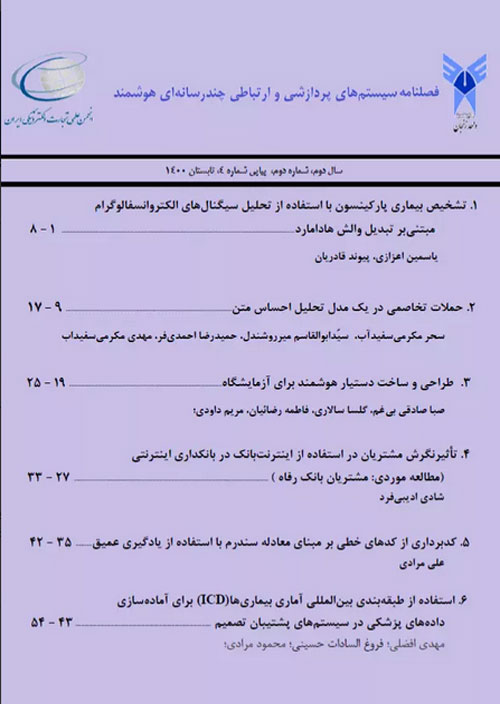

فهرست مطالب

نشریه سیستم های پردازشی و ارتباطی چند رسانه ای هوشمند

سال دوم شماره 2 (پیاپی 4، تابستان 1400)

- تاریخ انتشار: 1400/06/01

- تعداد عناوین: 6

-

تشخیص بیماری پارکینسون با استفاده از تحلیل سیگنال های الکتروانسفالوگرام مبتنی بر تبدیل والش هاداماردصفحات 1-8بیماری پارکینسون یکی از مهم ترین بیماری های سیستم عصبی است که به دلیل انحطاط نورون های دوپامینرژیک در جسم سیاه مغز رخ می دهد. از آنجایی که این بیماری درمان قطعی ندارد، بنابراین تشخیص کلینیکی و به موقع آن می تواند در کند نمودن سیر پیشرفت بیماری و ارایه راهکارهای کنترلی برای بهبود کیفیت زندگی بیماران نقش اساسی ایفا کند. در این مطالعه از تحلیل سیگنال الکتروانسفالوگرام به عنوان یک مشخصه کم هزینه، غیرتهاجمی و قابل اعتماد برای تشخیص استفاده شده است. روش پیشنهادی بر مبنای استخراج اطلاعات فرکانسی سیگنال به کمک تبدیل والش و محاسبه مجموعه ای از ویژگی ها مانند آنتروپی، معیارهای تکانش، ویژگی های آماری پایه و مرتبه بالا از ضرایب استخراج شده است. سپس، برای ارزیابی قدرت تفکیکی روش ارایه شده، از ماشین بردار پشتیبان و k نزدیک ترین همسایگی به منظور تفکیک بیماران از گروه سالم استفاده شده است. قابلیت تشخیص روش با استفاده از داده های الکتروانسفالوگرام 28 فرد سالم و 28 بیمار مبتلا به پارکینسون در حین انجام تکلیف یادگیری-تقویتی مورد ارزیابی قرار گرفته است. نتایج به دست آمده نشان داده است که روش پیشنهادی قادر است با استفاده از ویژگی آنتروپی، ماشین بردار پشتیبان و k نزدیک ترین همسایگی بیماری پارکینسون را به ترتیب با صحت بالای 99.95% و 99.98% تشخیص دهد.کلیدواژگان: بیماری پارکینسون، تکلیف یادگیری-تقویتی، تبدیل والش هادامارد، k نزدیک ترین همسایگی، ماشین بردار پشتیبان

-

صفحات 9-17: شبکه های عصبی عمیق دقت و کارایی بالایی در حل مسایل مختلف دارند اما در برابر نمونه های تخاصمی آسیب پذیر هستند. این دسته از نمونه های مخرب به منظور فریب مدل آموزش دیده و بررسی آسیب پذیری مدل های شبکه عصبی تولید می شوند. در حوزه متن روش های موفق زیادی برای ساخت این نمونه ها ارایه نشده است. در این پژوهش یک روش قوی مبتنی بر گرادیان تابع هزینه مدل برای تولید نمونه-های تخاصمی متنی ارایه شده و نشان داده شده که می توان با جایگزینی تعداد کمی از کلمات موجود در نمونه های اصلی با کلماتی که بیشترین تاثیر منفی را روی تصمیم طبقه بند دارند، نمونه های جدیدی مشابه با نمونه های اولیه برای فریب طبقه بند تحلیل احساس در سطح کلمه تولید نمود. در نهایت با بهره گیری از این نمونه ها دقت دو مدل طبقه بند از پیش آموزش دیده بررسی شد. روش مورد استفاده در این پژوهش، با دست کاری اندک نمونه های ورودی، موفق به کاهش دقت طبقه بندی از 86 درصد به کمتر از 10 درصد شده است.کلیدواژگان: حملات متنی، نمونه های تخاصمی، گرادیان تابع هزینه، تحلیل احساس، پردازش زبان طبیعی

-

صفحات 19-25امروزه آزمایشگاه های علمی به سمت هوشمند شدن می روند؛ با این حال، خواندن مراحل آزمایش و ثبت یافته ها غالبا هنوز هم با روش یادداشت برداری کاغذی انجام می گیرد که می تواند سبب انتقال آلودگی های میکروبی (انگل، قارچ، ویروس، باکتری) و شیمیایی (مانند آکریل آمید و مواد رادیواکتیوی) به وسایل شخصی و یادداشت های محقق شود که گاهی حتی نشر آلودگی به فضاهای خارج از آزمایشگاه را نیز به همراه دارد. هدف از این مطالعه، طراحی و ساخت ابزار کنترل هوشمند صوتی است که بتواند مراحل آزمایش و ثبت یافته ها را با فرمان های صوتی به یک نرم افزار طراحی شده در گوشی همراه پژوهشگر و بدون نیاز به لمس پیش ببرد. بخش سخت افزاری شامل یک برد الکترونیکی متشکل از چهار کلید عملیاتی (بعدی، قبلی، ضبط و اجرا) است که می تواند با استفاده از Wi-Fi و یا Hot spot به گوشی اندروید متصل شود. از طرف دیگر، بخش نرم افزاری شامل یک اپلیکیشن نوشته شده برای اندروید با زبان C Sharp است که با استفاده از Xamarian framework توسعه یافته است. به طور کلی، ابزار مهندسی شده روشی ساده و مقرون به صرفه است که با حذف روش یادداشت برداری کاغذی در آزمایشگاه می تواند سببب کاهش سیکل انتقال آلودگی ناشی از آن شود.کلیدواژگان: هوشمندسازی، آلودگی محیطی، سرایت، پروتکل های آزمایشگاهی

-

تاثیر نگرش مشتریان در استفاده از اینترنت بانک در بانکداری اینترنتی (مورد مطالعه : مشتریان بانک رفاه)صفحات 27-33

بانکداری اینترنتی یکی از روش های مورد استفاده در انجام عملیات بانکی است. تحقیق حاضر مدلی را ارایه می کند که درآن با توجه به کاهش هزینه و صرفه جویی در زمان و نقش اینترنت در ارانه خدمات بانکی ،عوامل موثر در شکل گیری نگرش ، در استفاده نهایی از اینترنت بانک در میان مشتریان بانک رفاه کارگران می پردازد.لذا عواملی همانند پذیرش فناوری ، عدالت درک شده از خدمات در راستای تعهد ، اعتماد و بر تمایل استفاده از خدمات بانکی و استفاده حقیقی از خدمات بانکداری نوین بررسی می گردد . جامعه آماری پژوهش مشتریان شعب بانک رفاه کارگران شهر تهران در نظر گرفته شد، و 384 پرسشنامه آزمون گردید و اطلاعات به روش نمونه گیری خوشه ای - تصادفی ساده توزیع و جمع آوری شده است.میزان اطمینان و صحت اعتبار پرسشنامه بررسی گردید. به منظور تجزیه وتحلیل اطلاعات گردآوری شده از روش مدل یابی معادلات ساختاری استفاده شد.نتایج حاصل از تحقیق تاثیر کیفیت، عدالت درک شده از خدمت، پذیرش فناوری و سازگاری بر نگرش، تاثیر کیفیت، نگرش و سازگاری بر رضایت، تاثیر رضایت بر اعتماد الکترونیک، تاثیر رضایت و اعتماد الکترونیک بر تمایل به استفاده و تاثیر تمایل به استفاده بر استفاده واقعی را مشخص می کند.پیشنهاد می شود بانکداری الکترونیک در بانک های دولتی تحول یابد و از انجاییکه بانکهای دولتی دارای منابع مالی دولتی هستند بنابراین می توانند زیر ساخت ها را تغییر داده و مشتریان بانکی نیز به بانکهای دولتی اطمینان بیشتری دارند تا سرمایه خود را در آنها سرمایه گذاری کنند .

کلیدواژگان: نگرش، اینترنت بانک، پذیرش فناوری، بانکداری اینترنتی -

صفحات 35-42استفاده از کدهای طول کوتاه در ارتباطات دیجیتال به خاطر فراگیر شدن پدیده اینترنت اشیاء از اهمیت ویژه ای برخوردار است. از طرفی مدل های یادگیری عمیق در زمینه های مختلفی مانند تشخیص اشیاء و تشخیص گفتار نتایج لبه علمی را بدست آورده اند. از این میان شبکه های کانولوشنی نقش اساسی در موفقیت مدل های یادگیری عمیق را دارند. برای افزایش دقت کدبرداری کدهای طول کوتاه (Low Density Parity Check Codes) بر مبنای معادله علامت از شبکه کانولوشنی استفاده گردید. برای تعیین جواب معادله علامت، از روش تشخیص الگوی خطا بهره گرفته شد. به این منظور، نخست شبکه کانولوشنی یک بعدی با سه لایه اصلی که هر لایه شامل زیرلایه های کانولوشن و ادغام میباشند استفاده شد. سپس خروجی شبکه کانولوشنی بر شبکه برگشتی GRU اعمال گردید. شبکه برگشتی GRU با تعداد سه برابر طول کدواژه با تابع فعالسازی ReLU مورد استفاده واقع گردید. تعیین مقدار ابرپارامترهای شبکه عصبی مورد استفاده ابتدا بصورت مقادیر پیش فرض کتابخانه تنسورفلو نسخه 2 مقدار دهی و در برخی موارد برای افزایش دقت تغییر داده شدند.مقایسه بین مدل ترکیبی حاصل از شبکه کانولوشنی یک بعدی و شبکه برگشتی با مدل شبکه برگشتی نشان می دهد که برای کد LDPC با طول 64 در کاهش نرخ خطای بیت، مدل ترکیبی حاصل از شبکه کانولوشنی و شبکه GRU بهتر عمل میکند. نرخ خطای بیت در شرایط نویزی مختلف به میزان 5.0 تا 8.0 دسیبل کمتر از میزان کدبردار بیشینه گر احتمال میباشد. همچنین نشان دادیم که شبکه های کانولوشنی در کنار شبکه های برگشتی پتانسیل این را دارند که بتوانند عملکرد چنین شبکه هایی را بهبود ببخشند.کلیدواژگان: کدینگ، یادگیری عمیق، شبکه های کانولوشنی، کدهای LDPC

-

صفحات 43-54کیفیت اطلاعات در موفقیت تجزیه و تحلیل اطلاعات بسیار حیاتی و مهم است. اطلاعات بارگذاری شده در انبارداده باید صحیح، دقیق و با کیفیت باشد. داده با کیفیت در انباره داده موجب تحلیل مناسب و تصمیم گیری بهتر می شود. همچنین مباحث کیفیت داده باید قبل از بارگذاری در انباره داده مورد توجه قرار بگیرد. پاکسازی داده به مفهوم یافتن و حذف خطاها است. همچنین در این فرایند داده های اضافی و ناسازگار شناسایی می شوند. پاکسازی داده در مرحله استخراج، انتقال، بارگذاری با اطمینان از کیفیت داده در انباره داده موجبات اثربخشی هوشمندی کسب و کار را فراهم می آورد. هدف پاکسازی داده، شناسایی داده های بد (اشتباه، نامرتبط و ناقص) به منظور اصلاح یا حذف آن ها است تا از دقت و سازگاری مجموعه داده اطمینان حاصل شود. این پژوهش با هدف تشریح و تبیین روش پاکسازی داده برای حذف داده های بد انجام شده است. بانک اطلاعاتی نمونه از اطلاعات بیماری های استان های زنجان، ایلام وهمدان تشکیل شده است. به منظور حل مشکلات داده در بانک نمونه از فرم سی شارپ و ابزاهای نرم افزار اس کیوال استفاده شده است. بخش اصلی نتایج نشان می دهد که بکارگیری روش پاکسازی داده موجب کاهش میزان خطای بانک داده تا میزان 008/0 درصد شده است.کلیدواژگان: هوش تجاری، آماده سازی داده، انباره داده، ICD، ILTEC

-

Pages 1-8Parkinson's disease (PD) is one of the most important diseases of the nervous system that occurs due to the degeneration of dopaminergic neurons in the substantia nigra. Since, there is no specific treatment for this disease, timely and clinical diagnosis can play a key role in slowing progression of the disease and providing control strategies to improve the quality of patients' life. In this study, EEG signals analysis has been used as a low-cost, non-invasive, and reliable approach. The proposed method is based on extracting frequency information of EEG signals with Walsh Hadamard transform and calculating a set of features, such as basic statistics, higher-order statistics, impulsive metrics, and entropy from the extracted coefficients. Then, in order to evaluate the proposed method, support vector machine and k nearest neighbor have been used to discriminate patients from the healthy group. The diagnostic ability of the method has been assessed using EEG data of 28 healthy individuals and 28 patients with PD during a reinforcement-learning task. The results showed that the proposed method can detect PD using entropy, support vector machine, and k nearest neighbor with accuracy of 99.95% and 99.98%, respectively.Keywords: Parkinson’s Disease, Reinforcement-learning task, Walsh Hadamard transform, K nearest neighbor, Support vector machine

-

Pages 9-17Deep neural networks have more accuracy and efficiency in solving various problems, but they are vulnerable to Adversarial Examples. Such malicious samples are built to deceive the trained model and to investigate the vulnerability of various neural network models. There are not many successful methods for making these examples in the text domain. In this paper, a robust method based on the model cost function gradient is presented for generating samples and shown that it is possible to replace a small number of words in the original samples with the words that have the most negative impact on classifier's decision to produce new samples similar to the original ones to deceive word level classifier. Finally, using these samples, the accuracy of two trained models were investigated. The method used in this study, by slightly manipulating input samples, has succeeded in reducing the classification accuracy from 86% to less than 10%.Keywords: Text Attacks, Adversarial Examples, Loss function gradient, Sentiment Analysis, natural language processing

-

Pages 19-25Despite the fact that laboratories are moving towards becoming smart, following the steps of a test protocol and recording new data are still done using paper notes during an experiment, resulting in spreading microbial (e.g. parasites, fungi, viruses, bacteria) and chemical (e.g. such as acrylamide and radioactive materials) contaminations. This study aimed to design an intelligent voice control tool that enables the researchers to read their different tests' steps and record their findings without any need for paper. The hardware includes an electronic board with four operational keys (i.e. next, previous, recording and play) that can be connected to the Android phone using Wi-Fi or Hot spot. In addition, a digital software was written in C Sharp language for Android and then developed using the Xamarian framework. In conclusion, the designed tool is able to reduce the contamination cycle due to the elimination of the paper-taking method in the laboratory.Keywords: intelligent designs, Environmental pollution, Contamination, protocol

-

Pages 27-33

Digital banking is one of the most important ways of doing financial transactions,

A model has been presented in this study,

considering the cost reduction and saving of time and Internet role in banking services, factors affecting the formation of attitudes,،

The impact of customers' expectations on the final use of Internet Bank among of the Refah Bank Customers. Therefore, factors such as technological acceptance,

perceived justice of services in terms of commitment, trust, and the willingness to use banking services and the Real use of banking services are reviewed.

The population of the present study is customers of all branches in Tehran.

So, 384 questionnaires were distributed among Customers cluster-random sampling method.

The reliability and Validity were examined. In order to analyze the collected data, structural equation modeling was used.

The results of the present study are the effect of quality, perceived justice of service, acceptance of technology and adaptation on attitude, the impact of quality, attitude and compatibility on satisfaction,

The effect of satisfaction on electronic trust, the effect of satisfaction and trust on the desire to use and the impact of the desire to use on Real used.

It is suggested that digital banking will be analyzed in public banks instead of private banks , because public banks have more financial resources to change their background into upgraded one. besides banking customer feel more reliable to invest their investments in public banks.Keywords: Customer attitude, Internet bank, technology acceptance, Digital Banking -

Pages 35-42Using short length codes has hight degree of importance because of I.O.T ubiquitous applications. Of course Deep Learning Methods has acquired state of the art results in object detection, speech processing and some other fields. Meanwhile, Convolutional Neural Network (CNN) models play a fundamental role in Deep Learning methods success. For boosting the accuracy of syndrome based decoding of Low Density Parity Check (LDPC) codes, convolutional neural network was used and for determining the solution of syndrome equations, error pattern recognition method was used. For this purpose a three layered CNN which any layer contains pooling and convolution sub-layer was used. Then output of CNN was applied to Gated Recurrent Unit(GRU). GRU recurrent network with rectified linear unit (ReLU) activation function and node count as three times as codeword length was used. For hyper parameter default value the Tensorflow 2.0 library’s default value was used except some hyper parameters which was altered manually for accuracy improvement reason. comparing between mixed model and bare recurrent model shows that for LDPC code with length of 64, bit error rate drops when mixed model used. In different signal to noise condition, bit error rate drops 0.5 to 0.8 Db toward Maximum Likelihood decoder. Also it is shown that CNNs have potential to improve recurrent networks accuracy when being used together.Keywords: Coding, deep learning, Convolutional neural networks

-

Pages 43-54Data quality is very crucial for the success Data analysis.The data loaded to the data warehouse must be correct, accurate and must be of very high quality.High quality data in the data warehouse will result in the better analysis and better decision making.So this data quality issues must be addressed before the data is loaded in to the data warehouse. Data cleaning find errors and remove errors.It also detect and deals with data redundancy and data inconsistency. Data cleaning using ETL to ensure quality data in the data warehouse for effective business intelligence. The purpose of data cleansing is to detect so called dirty data (incorrect, irrelevant or incomplete parts of the data) to either modify or delete it to ensure that a given set of data is accurate and consistent with other sets in the system. This research aims to explain and clarify data cleaning method for correcting dirty data. The sample database was defined as the collection of all diseases in the provinces of Zanjan, Elam and Hamedan. In order to solve the problems in the sample database C # and SQL store Procedure was applied. An important part of the results revealed the error after data cleaning was reduced to 0.008 %.Keywords: Business Intelligence (BI), Data Preparation, Data warehouse, ICD Code, ILTEC