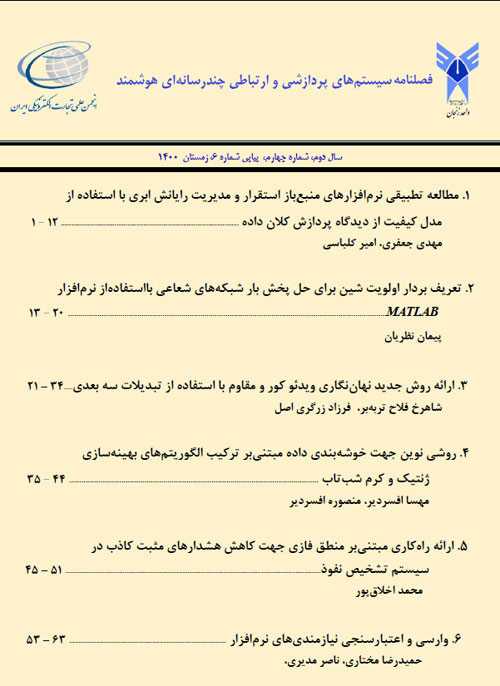

فهرست مطالب

نشریه سیستم های پردازشی و ارتباطی چند رسانه ای هوشمند

سال دوم شماره 4 (پیاپی 6، زمستان 1400)

- تاریخ انتشار: 1400/12/25

- تعداد عناوین: 6

-

صفحات 1-13روز به روز حجم داده های تولید شده توسط انسان ها در حال افزایش است. ذخیره سازی و پردازش داده ها، یکی از مباحث بسیار مهم در مواجهه با کلان داده ها است که نیازمند منابع ذخیره سازی و پردازشی گسترده می باشد. رایانش ابری به دلیل ویژگی ها و معماری خود، به عنوان یک زیرساخت امیدبخش برای این مساله مطرح است. برای ذخیره سازی و پردازش داده ها در بستر ابری، افراد و سازمان ها ممکن است برای کنترل و دسترسی بیشتر روی منابع و داده ها تمایل بیشتری به استقرار و مدیریت ابرهای خصوصی داشته باشند. برای استقرار و مدیریت ابرهای خصوصی نرم افزارهای متعدد منبع باز ارایه شده است که گزینش بین آنها به عنوان یک چالش به خصوص برای کسانی که تازه در این راه قدم بر می دارند مطرح است. هدف ما در این مقاله ارایه یک مدل کیفیت برای مدیریت زیرساخت ابری و مقایسه نرم افزارهای محبوب Eucalyptus، OpenStack و CloudStack بر اساس مدل کیفیت ارایه شده با تمرکز بر کلان داده به منظور نمایش قابلیت ها، ضعف ها و برتری های هر کدام در جهت کمک به گزینش بین آنها می باشد.کلیدواژگان: پردازش کلان داده، ذخیره سازی کلان داده، رایانش ابری، مدیریت ابر، مدل کیفیت

-

صفحات 13-20در این مقاله، با در نظر گرفتن روابط ساده مداری و با استفاده از یک الگوی پایه، یک شبکه شعاعی به شاخه های خود تقسیم می شود و با استفاده از توان معادل دیده شده در شین ها و اعمال یک بردار اولویت شین غیر یکتا، روش SDLF پیشنهاد می شود. نتایج اولین تکرار از روش SDLF در مقایسه با سایر روش ها و با یک تلرانس قابل قبول، به قدری دقیق است که می تواند در عملیات سیستم اسکادا، جهت پخش بار برخط، مورد استفاده قرار گیرد. اثربخشی روش پیشنهادی، با استفاده از نرم افزار MATLAB بر روی شبکه آزمون 33 شینه IEEE نشان داده می شود. همچنین این مقاله برخلاف سایر مقالات مرتبط، شامل کدهای خلاصه و ساده MATLAB است به طوری که از تعریف ماتریس های اضافی و پیچیده در روش پیشنهادی، اجتناب می شود. استفاده از یک تکرار به جای چند تکرار و همچنین کاهش حجم محاسبات باعث می شود که زمان انجام مطالعات پخش بار کاهش یابد.کلیدواژگان: نرم افزار MATLAB، آنالیز پخش بار برخط، سیستم های توزیع شعاعی، اسکادا

-

صفحات 21-34نهان نگاری ویدیو با استفاده از تبدیلات سه بعدی، ویدیوی نهان نگاری شده را در برابر حملاتی مانند میانگین گیری فریم، تبانی و... مقاوم تر می کند. نهان نگاری با استفاده از تبدیلات سه بعدی به عنوان راهکاری در مقابله با مشکلات ناشی از نهان نگاری مستقل امضا در یک یا چند فریم استفاده می شود. در این مقاله یک الگوریتم نهان نگاری ویدیو کور مقاوم جدید بر پایه تبدیل سه بعدی پیشنهاد شده است. تبدیل به کارگرفته ترکیبی از تبدیل کانتورلت دو بعدی و تبدیل موجک گسسته یک بعدی است. در روش پیشنهادی، هر فریم از ویدیو به ستون های فرد و زوج سه بعدی تقسیم می شود. تبدیل بر روی هر دوی آنها اعمال می شود و امضا در قسمت زوج ویدیو با استفاده از ضریب انرژی بالای قسمت فرد گنجانده می شود. نتایج آزمایشات حاکی از افت کیفیت ناچیز ویدیو نهان نگاری شده و کیفیت مناسب امضا استخراجی می باشد همچنین روش پیشنهادی در برابر حملات رایج ویدیوهای نهان نگاری شده مقاومت مناسب تری نسبت به راهکارهای مشابه ارایه می کند.کلیدواژگان: نهان نگاری کور ویدئو، تبدیلات سه بعدی، تبدیل کانتورلت، تبدیل موجک

-

صفحات 35-44یکی ازمسایل مهم درداده کاوی خوشه بندی است که بدون هدف ازپیش تعیین شده ای داده هارابراساس شباهت درون خوشه ها تقسیم بندی می کند.ازروش های متداول خوشه بندی الگوریتم k-means است که بادریافت ورودی،داده هارابه k خوشه تقسیم بندی می کند.یکی ازمعایب این روش حساسیت به شرایط اولیه است که منجربه کاهش دقت درخوشه بندی می شود.ازروش های بهبودعملکرد k-means می توان استفاده ازالگوریتم های فراابتکاری رانام برد.دراین پژوهش به دوروش بهینه سازی ژنتیک وکرم شب تاب پرداخته شده است والگوریتم جدیدی تحت عنوان الگوریتم ژنتیکی کرم شب تاب جهت بهینه سازی خوشه بندی k-means ارایه شده است.الگوریتم کرم شب تاب ازالگوریتم های هوش جمعی است که ازویژگی نورچشمک زن کرم شب تاب الهام گرفته است والگوریتم ژنتیک نوعی ازالگوریتم های فراابتکاری است که ازتکنیک-های زیست شناسی مانندوراثت وجهش استفاده می کند.در الگوریتم k-means برای اینکه مراکز خوشه به صورت تصادفی انتخاب می شوند،خوشه بندی دقت لازم راندارد.بااستفاده ازالگوریتم های فراابتکاری سعی دربدست آوردن مراکزدقیق خوشه هاداشته ودرنتیجه آن،خوشه-بندی صحیح می باشیم.درروش پیشنهادی،ابتداالگوریتم k-means راروی داده های ورودی اجراکرده وخوشه بندی انجام می شود.سپس مضربی ازمراکز خوشه که دراین الگوریتم بدست آمده است رابه عنوان حدپایین وحدبالای الگوریتم پیشنهادی استفاده می کنیم. جمعیت اولیه به صورت تصادفی بین حدپایین وحدبالاتولیدمی شود. درحلقه اصلی الگوریتم جمعیت رابه دودسته جمعیت مساوی تقسیم می نماییم برروی دسته اول الگوریتم ژنتیک رااجرامی کنیم،برروی دسته دوم براساس الگوریتم کرم شب تاب موقعیت های جدیدرابدست می آوریم.حال جمعیت قبلی و جمعیت جدید بدست امده ازالگوریتم ژنتیک وجمعیت جدید بدست امده ازالگوریتم کرم شب تاب راتلفیق کرده وآن هاراازخوب به بد مرتب می کنیم وبه تعدادموردنیاز ازآن هارا انتخاب وبه ابتدای حلقه می رویم.این فرایندراتابرقراری شرط توقف ادامه می دهیم.درپایان الگوریتم k-means،الگوریتم کرم شب تاب،الگوریتم ژنتیک والگوریتم پیشنهادی بر روی سه مجموعه داده اعمال شده ونتایج موردمقایسه قرارگرفته است.نتایج شبیه سازی نشان می دهدکه الگوریتم ژنتیکی کرم شب تاب عملکردبهتری درمقایسه باسایرروش ها داشته است.کلیدواژگان: داده کاوی، الگوریتم ژنتیک، الگوریتم کرم شب تاب، الگوریتم ژنتیکی کرم شب تاب، خوشه بندی k-means

-

صفحات 45-51سیستم تشخیص نفوذ به عنوان اولین خط دفاعی برای شبکه ضروری است. الگوریتم های زیادی در کیفیت مجموعه داده های ارایه شده برای شناسایی نفوذ بستگی دارد. البته در تحولات اخیر در سیستم های دستیابی به مجموعه داده های دانش باعث افزایش علاقه در رویکردهای داده محور برای مهار افزایش حملات سایبری سیستم کنترلی مرتبط با هشدارهای کاذب شده است. بیشتر سیستم های تشخیص نفوذ مبتنی بر یادگیری ماشین به منظور شناسایی حملات هدفمند توسط میزبان یا شبکه به برنامه های وب / سیستم عامل یا سطح شبکه متکی هستند. با این وجود، متاسفانه کمبود تحقیقات کافی در ارزیابی و جمع آوری مجموعه داده های مربوط به سیستم تشخیص نفوذ برای رفتارهای هشدارهای کاذب هم چنان وجود دارد، که مستلزم مطالعات بیشتر در این حوزه را می طلبد. در این مقاله عملکرد سیستم تشخیص نفوذ، به منظور تاثیر رفتار سیستم تشخیص سوءاستفاده و هم چنین تشخیص ناهنجاری با استفاده از منطق فازی مبتنی بر دستگاه آلفا ارایه گردیده است. نتایج به دست آمده میزان دقت را تا 26/91% و تشخیص هشدارهای کاذب را تا میزان 96/90% نشان داده است.کلیدواژگان: سیستم تشخیص نفوذ، هشدارهای کاذب، شبکه های کامپیوتری، منطق فازی

-

صفحات 53-63چکیده هدف اصلی شرکت های نرم افزاری ارایه راه حل هایی در حوزه های مختلف برای تحقق بهتر نیازهای مشتریان می باشد. روند موفقیت آمیز بودن مدل سازی، بستگی به یافتن نیازمندی های صحیح و دقیق دارد. با این حال، کلید توسعه موفقیت آمیز برای تطبیق و ادغام بخشهای مختلف توسعه یافته به اهمیت انتخاب و اولویت بندی نیازمندی هایی که باعث پیشرفت مراحل کار و در نهایت منجر به ایجاد محصول با کیفیتی خواهد شد اشاره دارد. اعتبار سنجی کلیدی ترین بخش کار می باشد، که شامل تکنیک هایی است که صحت مجموعه ای از نیازمندی های مشخص شده را برای ساخت یک راه حل که منجر به اهداف کسب و کار پروژه می شود، تایید می کند. نیازمندی ها در طول پروژه تغییر می کنند و مدیریت این تغییرات برای حصول اطمینان از صحت نرم افزار ساخته شده برای ذینفعان اهمیت بسیاری دارد. در این پژوهش به فرآیند وارسی و اعتبار سنجی نیازمندی های نرم افزار می پردازیم.کلیدواژگان: وارسی، اعتبارسنجی، نیازمندی، نرم افزار

-

Pages 1-13The volume of data produced by human society is growing rapidly. Data storage and processing is one of the most important issues in dealing with big data that requires extensive storage and processing resources. Cloud computing, due to its features and architecture, is a promising infrastructure for the purpose of processing big data. To store and process data in a cloud environment, individuals and organizations may be more inclined to deploy and manage private clouds to gain greater control and access to resources and their data. Numerous open-source software has been developed for the deployment and management of private clouds. Choosing among them is a challenging task, especially for those who are new to these software systems. In this paper, first of all, we provide a quality model for cloud infrastructure management software and then compare three of the popular choices, namely, Eucalyptus, OpenStack, and CloudStack based on the quality model presented with a focus on big data to show their capabilities, weaknesses, and strengths.Keywords: Big Data Processing, Big Data Storage, cloud computing, Cloud Management, Quality Model

-

Pages 13-20IntroductionLoad distribution analysis is a fundamental and basic study for all power networks, including distribution networks, which are used in steady-state conditions. Power system planning and operation, power network reorganization, and many optimization studies require a large number of load distribution calculations in normal and emergency situations. Due to the nonlinearity of the system of load distribution equations, it is necessary to use iterative solution methods to solve it. In addition, due to a large number of power grid buses, matrix algebra is used. Some of these applications require fast iterative solutions of load distribution and therefore it is very important that load distribution analysis is performed efficiently. A number of load distribution algorithms are specifically designed for distribution systems. One of these methods considers bus voltages as state variables and works based on an iterative algorithm and uses special methods to increase convergence.MethodThe proposed algorithm of this paper called SDLF in this article does not need special matrices and complex programming. In this method, load distribution can be achieved easily with only a simple vector that shows the priority of buses, which we call BPV, and by using the forward-backward sweeper algorithm. It is worth mentioning that the BPV vector itself is extracted from the network topology. This work can be done both visually from the electrical diagram of the network and from the data matrix of network D by MATLAB software.FindingIn terms of the convergence of the solution, increasing the repetition has led to an increase in accuracy, and as a result, the 10th repetition has been chosen as a relatively accurate result to confirm the validity of the method, considering the required engineering precision. The obtained results show that even in the first iteration, an acceptable accuracy for the voltage range has been obtained. In steady state analysis of power networks, the voltage amplitude is more important than the voltage phase. The noteworthy point is that in calculating the voltage phase, it is not necessary to update its value in each step, and it is enough to calculate the voltage phase after obtaining the voltage ranges.ConclusionIn this article, a new method called SDLF is introduced to study the load distribution of distribution networks. The results of the implementation of the proposed method, with an acceptable engineering error, can be used in the common applications of power networks in the first iteration, and based on this, it can be used as an online load distribution in SCADA systems. The effectiveness of the method was checked on the test network of 33 IEEE buses in the text of the article and its validity was confirmed. The introduction of the BPV bus priority vector made it possible to avoid using complex matrices and additional calculations and to reduce the time of load distribution calculations.Keywords: MATLAB Software, online load flow analysis, Radial Distribution Systems, SCADA

-

Pages 21-34IntroductionDigital images and videos can be copied, reproduced, and distributed with the same quality as the original ones, and this violates the copyright of original producers and the distributors. As a result, embedding information about the original producer and distributor in digital images and video attracted great attention for digital right management. Watermarking provides the facility to embed the required information in images and videos. Robust watermarking is used for embedding authentication information and hence should be robust against various attacks. On the other hand, in fragile watermarking the embedded data should be destroyed by any alteration in the watermarked image or video. Reversible digital watermarking techniques are proposed for lossless restoration of the original image from the watermarked image. Watermarking is non-blind when a copy of the signature or other related information is required for extracting the signature from the watermarked image or video and is blind when the signature can be extracted from watermarked data without any other subsidiary information. Watermarking the signature in a group of successive frames of a video file by the use of 3-D transforms attracted attention because it makes the watermarked video more robust against attacks such as frame averaging and alteration, and watermarking by 3-D transform is employed as a solution to the problems caused by independent watermarking of signature in one or several frames.MethodsContourlet transform offers a high degree of directionality and anisotropy besides the multi-scale and time-frequency localization properties in wavelet transform. As a result, Contourlet transforms the representation of curved edges in the images with smoother contour and fewer coefficients compared to the wavelet transform. In this paper, a blind robust watermarking method based on a hybrid 3-D transform is proposed. The hybrid 3-D transform is derived by employing the 2-D Contourlet transform along with the 1-D wavelet transform. The signature will be watermarked in the low-frequency sub-band derived from the third level transform. To watermark the signature, we save a modified copy of the high energy coefficients of the even part in the odd part. For signature extraction, the watermarked region is partitioned into odd and even columns. The 3-level 3-D is applied to odd and even parts to transform coefficients. The high-energy sub-bands in odd and even parts are separated to extract the signature.ResultsExperimental results indicate low degradation of the quality of the watermarked video, along with high robustness of the watermarked video against common attacks in comparison with other tested blind video watermarking methods.DiscussionA comparison of the proposed method with other methods indicates the superior performance of the proposed method in most of the attacks.Keywords: Blind video watermarking, 3-D transform, Contourlet Transform, Wavelet Transform

-

Pages 35-44IntroductionWith the progress of technology and increasing the volume of data in databases, the demand for fast and accurate discovery and extraction of databases has increased. Clustering is one of the data mining approaches that is proposed to analyze and interpret data by exploring the structures using similarities or differences. One of the most widely used clustering methods is the k-means. In this algorithm, cluster centers are randomly selected and each object is assigned to a cluster that has maximum similarity to the center of that cluster. Therefore, this algorithm is not suitable for outlier data since this data easily changes centers and may produce undesirable results. Therefore, by using optimization methods to find the best cluster centers, the performance of this algorithm can be significantly improved. The idea of combining firefly and genetics algorithms to optimize clustering accuracy is an innovation that has not been used before.MethodIn order to optimize k-means clustering, in this paper, the combined method of genetic algorithm and firefly worm is introduced as the firefly genetic algorithm.FindingsThe proposed algorithm is evaluated using three well-known datasets, namely, Breast Cancer, Iris, and Glass. It is clear from the results that the proposed algorithm provides better results in all three datasets. The results confirm that the distance between clusters is much less than the compared approaches.

Discussion andConclusionThe most important issue in clustering is to correctly determine the cluster centers. There are a variety of methods and algorithms that performs clustering with different performance. In this paper, based on firefly metaheuristic algorithms and genetic algorithms a new method has been proposed for data clustering. Our main focus in this study was on two determining factors, namely the distance within the data cluster (distance of each data to the center of the cluster) and the distance that the headers have from each other (maximum distance between the centers of the clusters). In the k-means algorithm, clustering is not accurate since the cluster centers are selected randomly. Employing firefly algorithms and genetics, we try to obtain more accurate centers of the clusters and, as a result, correct clustering.Keywords: Data mining, genetic algorithms, firefly algorithm.Firefly Genetic Algorithm. k-means algorithm -

Pages 45-51IntroductionThe intrusion detection system is responsible for identifying and detecting unauthorized external use of the system that is misused or damaged by internal users. Therefore, the intrusion detection system is created in the form of software and hardware, each of which has its own advantages and disadvantages. The speed and accuracy of the hardware system and the failure of their security by intruders are other features of such systems. If the software related to intrusion detection, acceptability, and the difference between different operating systems are used, they give more generality to the software systems. More suitable software systems are chosen.MethodThe behavior of the intrusion detection system is discussed in opposition to various intrusion methods, and in order to deal with intrusion into the system and computer networks, several methods have been created under the name of intrusion detection, which monitors the events that have occurred in a system and into computer networks.Resultsthe performance of the intrusion detection system is presented in order to influence the behavior of the abuse detection system as well as anomaly detection using fuzzy logic based on an alpha device. The obtained results showed the accuracy rate up to 91.26% and the detection of false alarms up to 90.96%.DiscussionAn Intrusion detection system is essential as the first line of defense for the network. Many algorithms depend on the quality of the data set provided for intrusion detection. Of course, in recent developments in knowledge data collection access systems, there has been an increase in interest in data-driven approaches to curb the increase in control system cyber-attacks related to false alarms. Most machine learning-based intrusion detection systems rely on web applications/operating systems or network layers to detect targeted attacks by host or network. Nevertheless, there is still a lack of sufficient research in the evaluation and collection of intrusion detection system datasets for false alarm behaviors, which requires further studies in this field.Keywords: Intrusion Detection System, False Alarms, Computer Networks, fuzzy logic

-

Pages 53-63IntroductionThe main goal of software companies is to provide solutions in various fields to better meet the needs of customers. The process of successful modeling depends on finding the right and accurate requirements. However, the key to successful development for adapting and integrating different developed parts is the importance of selecting and prioritizing the requirements that will advance the workflow and ultimately lead to the creation of a quality product. Validation is the key part of the work, which includes techniques that confirm the accuracy of a set of requirements for building a solution that leads to the project's business objectives. Requirements change during the project, and managing these changes is important to ensure the accuracy of the software built for stakeholders. In this research, we will discuss the process of checking and validating the software requirements.MethodRequirement extraction is conducted by means of discovery, review, documentation, and understanding of user needs and limitations of a system. The results are presented in the form of products such as text requirements descriptions, use cases, processing diagrams, and user interface prototypes.FindingsData mining and recommender systems can be used to increase the necessary needs, however, another method of social networks and joint filtering can be used to create requirements for large projects to identify needs.DiscussionIn the area of product development, requirements engineering approaches focus exclusively on requirement development. There are challenges in the development process due to the existence of human resources. If the challenges are not seen well at this stage, it will be extremely expensive after the software production. Therefore, in this regard, errors should be minimized and they should be identified and corrected as soon as possible. Now, with the investigations carried out, one of the key issues in the field of requirements is the discussion of validation, which first confirms that the requirements are able to be implemented in a set of characteristics according to the system description, and secondly, a set of essential characteristics. such as complete, consistent, according to standard criteria, non-contradiction of requirements, absence of technical errors, and lack of ambiguity in requirements. In fact, the purpose of validation is to ensure the result that a sustainable and renewable product is created according to the requirements.Keywords: Verification, Validation, Development, Requirement, Software